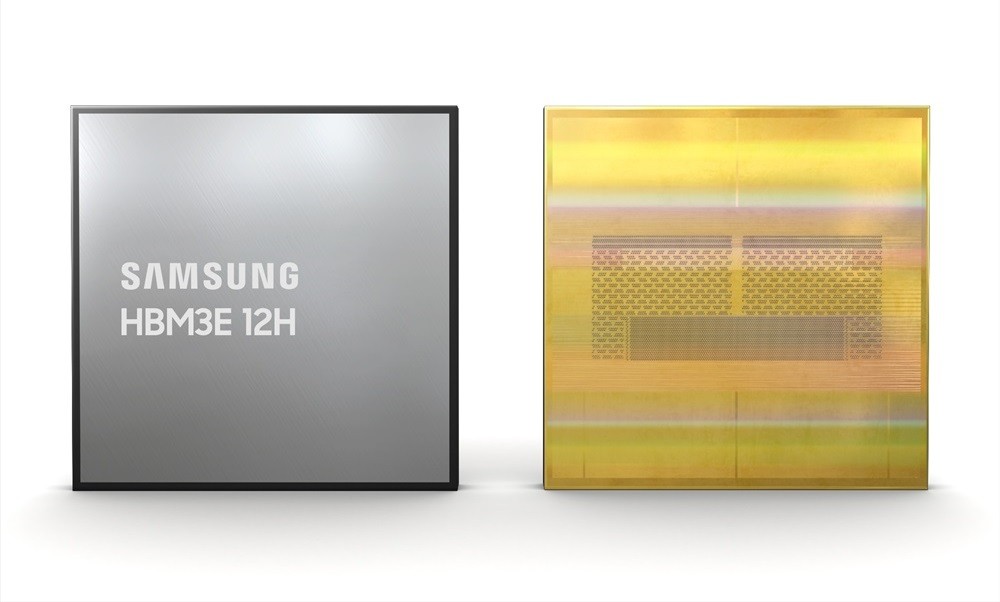

In un mondo tecnologico che avanza a passi da gigante, Samsung si è nuovamente distinta annunciando l’ultimo gioiello della sua corona tecnologica: la memoria DRAM HBM3E 12H, impreziosita dalla rivoluzionaria tecnologia TC NCF. Questo annuncio non solo suscita entusiasmo tra gli esperti di tecnologia ma segna anche un punto di svolta significativo per le applicazioni di intelligenza artificiale, promettendo di accelerare notevolmente i processi di apprendimento automatico e di inferenza.

Che Cos’è la Memoria HBM3E?

La sigla HBM sta per High Bandwidth Memory, o memoria ad alta larghezza di banda, un tipo di memoria che si distingue per la sua capacità di offrire velocità di trasferimento dati eccezionalmente elevate. La versione HBM3E Shinebolt introdotta da Samsung ad ottobre rappresenta l’apice di questa tecnologia, con prestazioni che raggiungono i 9,8Gbps per pin, equivalente a una larghezza di banda totale di 1,2 terabyte al secondo per l’intero pacchetto.

L’Innovazione del Design 12H

Il cuore dell’innovazione di Samsung risiede nel suo design 12H, che si riferisce al numero di chip impilati verticalmente all’interno di ogni modulo di memoria. Con 12 chip impilati, Samsung non solo ha incrementato la capacità di memoria raggiungendo i 36GB per modulo, ma ha mantenuto inalterata la larghezza di banda a 1,2 terabyte al secondo, offrendo un miglioramento del 50% rispetto ai precedenti design 8H.

La Rivoluzionaria Tecnologia TC NCF

TC NCF sta per Thermal Compression Non-Conductive Film, una pellicola non conduttiva utilizzata nello spazio tra i chip impilati. Samsung ha affinato questa tecnologia riducendone lo spessore a soli 7µm. Questo non solo ha permesso di mantenere lo stack 12H alla stessa altezza dello stack 8H, facilitando l’uso degli stessi imballaggi HBM, ma ha anche migliorato significativamente le proprietà termiche della memoria, contribuendo a una migliore dissipazione del calore e migliorando le rese di produzione.

Un Futuro Luminoso per l’AI

L’impiego più promettente della memoria HBM3E 12H di Samsung è nell’ambito dell’intelligenza artificiale, dove la domanda di RAM ad alte prestazioni è insaziabile. La collaborazione con giganti della tecnologia come Nvidia, che ha integrato la memoria HBM3E di Samsung nei suoi GPU Tensor Core H200, evidenzia l’importanza cruciale di questa memoria per il futuro dell’AI. Questi GPU, con una capacità fino a 141GB e una larghezza di banda di 4,8 terabyte al secondo, stanno già spingendo i limiti delle attuali applicazioni AI, promettendo un’accelerazione del 34% nell’apprendimento automatico e una capacità di gestione degli utenti inferiore più di 11 volte superiore.

Conclusione

L’innovazione di Samsung con la sua memoria HBM3E 12H non solo segna un passo avanti significativo nel campo della tecnologia di memoria ma apre anche nuove strade per l’evoluzione dell’intelligenza artificiale. Con una capacità e una velocità di trasferimento dati senza precedenti, questa tecnologia promette di rivoluzionare il modo in cui elaboriamo e interagiamo con enormi quantità di dati, rendendo l’AI più accessibile, efficiente e potente che mai.